科技

谷歌麻省理工学院的最新研究证明,获得高质量数据并不难,大模型才是回头路。

谷歌麻省理工学院的最新研究证明,获得高质量数据并不难,大模型才是回头路。

从数据中获取最新的解决方案就是向生成模型学习。

获取高质量数据已成为当前大型模型训练的主要瓶颈。

日前,《纽约时报》被起诉,要求赔偿数十亿美元。 投诉列出了 GPT-4 抄袭的多项证据。

《纽约时报》甚至呼吁销毁GPT等几乎所有大型模型。

许多AI行业的大佬长期以来都认为“合成数据”可能是解决这个问题的最佳方案。

此前,团队还提出了RLAIF,一种利用LLM替代人类标签偏好的方法,效果甚至不逊色于人类。

现在,谷歌和麻省理工学院的研究人员发现,从大型模型中学习可以产生使用真实数据训练的最佳模型的表示。

这种最新方法声称是一种完全从合成图像和合成描述中学习虚拟表示的方法,无需任何真实数据。

论文地址:

实验结果表明,该方法学习到的表示可以与CLIP的传输效果一样好。

01 从生成模型中学习

目前表现最好的“视觉表示”学习方法依赖于大规模的现实世界数据集。 然而,收集真实数据存在很多困难。

为了降低收集数据的成本,本文研究人员提出了一个问题:

从现成的生成模型中采样的合成数据是否是大规模整理数据集以训练最先进的视觉表示的可行途径?

谷歌研究人员称这种模型为“从模型中学习”,而不是直接从数据中学习。 作为构建大规模训练集的数据源,模型有几个优点:

- 通过潜在变量、条件变量和超参数为数据管理提供新的控制方法。

- 模型也更容易共享和存储(因为模型比数据更容易压缩),并且可以产生无限数量的数据样本。

越来越多的文献研究了生成模型作为训练下游模型的数据源的这些属性以及其他优点和缺点。

其中一些方法采用混合模型,即混合真实数据集和合成数据集,或者需要一个真实数据集来生成另一个合成数据集。

其他方法尝试从纯粹的“合成数据”中学习表示,但远远落后于性能最佳的模型。

论文中,研究人员提出的最新方法利用生成模型重新定义可视化类的粒度。

如图2所示,使用2个提示生成了4张图像:“一只戴着墨镜、戴着沙滩帽骑自行车的金毛猎犬”和“一只可爱的金毛猎犬坐在由寿司制成的房子里”。

传统的自监督方法(例如 Sim-CLR)将这些图像视为不同的类,并且不同图像的嵌入是分离的,而没有明确考虑图像之间的共享语义。

在另一个极端,监督学习方法(即 SupCE)将所有这些图像视为一个类别(例如“金毛猎犬”)。 这忽略了图像中的语义细微差别,例如一对图像中的狗骑着自行车,而另一对图像中的狗坐在寿司店里。

相反,该方法将描述视为类,即每个描述一个可视化类。

这样,我们就可以根据“骑自行车”和“坐在寿司店”这两个概念对图像进行分组。

这种粒度很难在实际数据中挖掘,因为通过给定描述收集多个图像并非易事,尤其是当描述数量增加时。

然而,文本到图像的扩散模型从根本上具有这种能力。

通过简单地以相同的描述为条件并使用不同的噪声输入,文本到图像的扩散模型可以生成与相同描述相匹配的不同图像。

具体来说,作者研究了在没有真实图像或文本数据的情况下学习视觉编码器的问题。

最先进的方法依赖于 3 个关键资源的利用:语言生成模型 (g1)、文本到图像生成模型 (g2) 和视觉概念的精选列表 (c)。

预处理包括三个步骤:

(1)使用(g1)合成一套全面的图像描述T,涵盖C中的各种视觉概念;

(2) 对于T中的每个标题,使用(g2)生成多个图像,最终生成一个广泛的合成图像数据集X;

(3) 对X进行训练以获得视觉表示编码器f。

然后,由于推理速度快,分别使用 llama-27b 和 1.5 作为(g1)和(g2)。

综合描述

为了利用强大的文本到图像模型的强大功能来生成大型训练图像数据集,首先需要一组描述,这些描述不仅能够准确描述图像,而且能够表现出多样性以涵盖广泛的视觉概念。

在这方面,作者开发了一种可扩展的方法来创建如此大的描述集,利用大型模型的上下文学习功能。

下面显示了合成模板的三个示例。

以下是使用 Llama-2 生成的上下文描述。 研究人员在每次推理运行中随机抽取了三个上下文示例。

合成图像

对于每个文本描述,研究人员使用不同的随机噪声开始反向扩散过程,从而产生各种图像。

在此过程中,无分类器自举(CFG)比率是关键因素。

CFG尺度越高,样本的质量越好,文本与图像的一致性越好,而尺度越低,样本的多样性越大,越接近基于图像的原始条件分布在给定的文本上。

表征学习

论文中提出了表示学习方法。

作者提出的方法的关键组成部分是多重正对比学习损失,它的工作原理是对齐(在嵌入空间中)从相同描述生成的图像。

此外,该研究还结合了其他自监督学习方法的各种技术。

02 与 CLIP 相当

对于实验评估,研究人员首先进行了消融研究,以评估管道内各种设计和模块的有效性,然后继续扩大合成数据量。

下图是不同描述合成策略的比较。

研究人员报告了九个细粒度数据集的线性评估精度和平均精度。 这里的每个项目都包含 1000 万条描述,每个描述有 4 张图片。

下表将线性评估与细粒度分类进行了比较。

尽管仅使用合成数据,但 CLIP 和 DINO v2 模型也取得了可比较的结果。

下表对相同合成数据上的 CLIP 与 CLIP 进行了比较。 可以看出明显优于CLIP。

具体设置为每个标题生成4张图片,-150M为CLIP提供了更好的表示。

PCA可视化如下。 在 DINO v2 之后,研究人员计算了同一组图像的补丁之间的 PCA,并根据前 3 个分量对它们进行着色。

与DINO v2相比,汽车和飞机的绘图更加准确,而能力的绘图稍微不太准确。

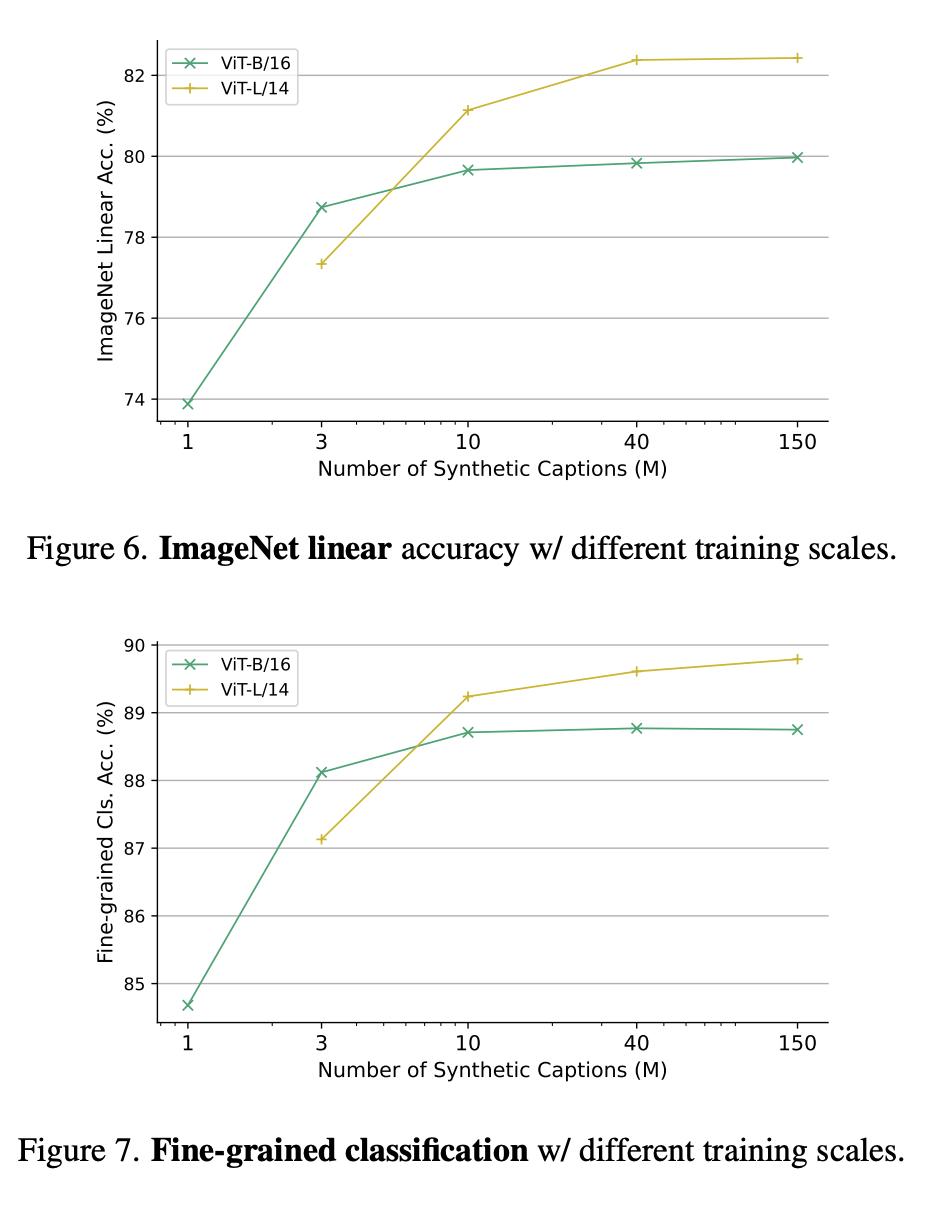

图6和图7分别展示了不同训练尺度下的线性精度和不同训练参数尺度下的精细分类。

为什么要从生成模型中学习?

一个令人信服的原因是,生成模型可以同时对数百个数据集进行操作,从而提供了一种方便且有效的方法来管理训练数据。

总之,最新论文研究了视觉表示学习的新范式——从生成模型中学习。

学习到的视觉表示与最先进的通用视觉表示学习者在不使用任何真实数据的情况下学习到的视觉表示相当。

参考:

本文来自微信公众号“新智元”(ID:),作者:新智元,36氪经授权发布。