对于直流运营商来说,英伟达的布莱克威尔效率收益意味着什么

分析 在上周的GTC发布了1,200瓦的布莱克威尔GPS之前,热火朝天的CPU和GPS已经让数据中心运营商感到头疼。

过去一年,数据中心运营商和共用服务提供商 扩大支持 对于高密度部署,通过后门换热器(RDHX)和在某些情况下直接到芯片(DTC)液体冷却,预期芯片温度上升。

看一下英维迪亚的 布莱克韦尔阵容 ,这些修改似乎是有理由的。每架大约60千瓦--每个节点14.3千瓦--已经有四个DGXB200系统堆了。 推动的 数字房地产设施中标准风冷架的限制。

那甚至不是英伟达最强大的系统。它最新的GB200Nvl72型系统 看着 详细地说,上周的评级为120千瓦,而且--并不出人意料--绝对需要液体冷却。

这对机架上的灯芯来说是很大的热量,但故事的内容却更多。让我们来看看布莱克韦尔的动力和效率的提高。

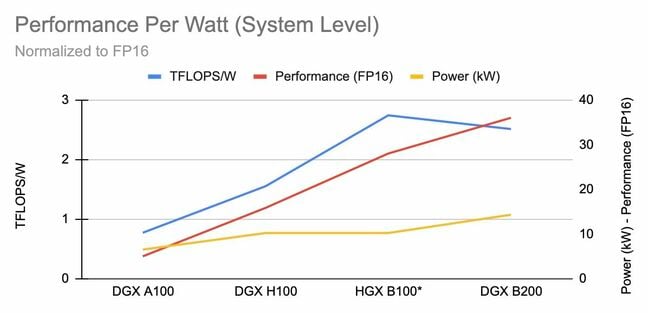

每瓦性能在布莱克韦尔的发布期间,英伟达大胆地声称其芯片的性能和效率。我们稍后会讨论这些问题,但现在让我们看看这些芯片是如何按每瓦未加工浮点操作来堆叠的。

全球特别行动区f/w B100 (SXM) B200 (SXM) GB200 (GPU only) H100 (SXM) A100 (SXM) TDP 700W 1,000W 2,400W 700W 400W TF32 2.6 TFLOPS/W 2.2 TFLOPS/W 2.08 TFLOPS/W 1.41 TFLOPS/W 0.78 TFLOPS/W FP16 5 TLOPS/W 4.5 TFLOPS/W 4.16 TFLOPS/W 2.82 TFLOPS/W 1.56 TFLOPS/W FP8/INT8 10T(FL)OPS/W 9 T(FL)OPS/W 8.33 T(FL)OPS/W 5.65 T(FL)OPS/W 3.12 TOPS/W FP4 20TFLOPS/W 18 TFLOPS/W 16.66 TFLOPS/W 无 无注意:在这个阵容中,我们没有包括fp64的性能,因为布莱克威尔实际上在双重精确工作量中的表现比霍普尔差。

仅从GPU效率来看,布莱克韦尔表现出了强劲的收益,比霍普高1.7x,比正常化为pp16的安培高3.2x。显然,如果你的工作量可以利用较低的精确度,那么你可以期待看到更大的收益,但结论基本相同。

但是当我们比较布莱克韦尔GPU的sku时,我们开始看到性能回报的递减超过了700W的标准。虽然看起来我们只是用1,000瓦的b200和gb200的双200瓦加速器来交换电力。

与H100不同的是,布莱克威尔的零部件还没有单独的PCI卡。

这意味着您将把它们作为hgx、dgx或超芯片衍生配置的一部分来购买。这意味着最小的配置将是两个GPS与GB200或八个与HGXB100或B200基系统。

系统专用/西 HGX B100* DGX200 Gb200Nvl72 DGXH100 DGXA100 TDP 10.2kW 14.3kW 120kW 10.2kW 6.5kW TF32 1.41 TFLOPS/W 1.23 TFLOPS/W 1.5 TFLOPS/W 0.77 TFLOPS/W 0.38 TFLOPS/W FP16 2.74 TFLOPS/W 2.51 TFLOPS/W 3 TFLOPS/W 1.55 TFLOPS/W 0.76 TFLOPS/W FP8/INT8 5.49 T(FL)OPS/W 5.03 T(FL)OPS/W 6 T(FL)OPS/W 3.10 T(FL)OPS/W 1.53 T(FL)OPS/W FP4 10.98 TFLOPS/W 10.06TFLOPS/W 12 TFLOPS/W 无 无注:由于没有DGXB100配置,我们的"HGXB100"数字是以DGXH100的最大功率提取为基础的,因为这是一个可供选择的替换,设计的目的是在相同的热和功率约束下工作。

通过观察充满CPU、内存、网络和存储器的风冷系统的效率,我们发现,即使拥有更大的10U底盘来容纳更大的堆栈,dgxb200似乎也不如hgxb100高效。

怎么了?正如你可能已经怀疑的那样,1000W比700W更难冷却,特别是因为风扇必须更快地旋转,以推动更多的空气通过热池。

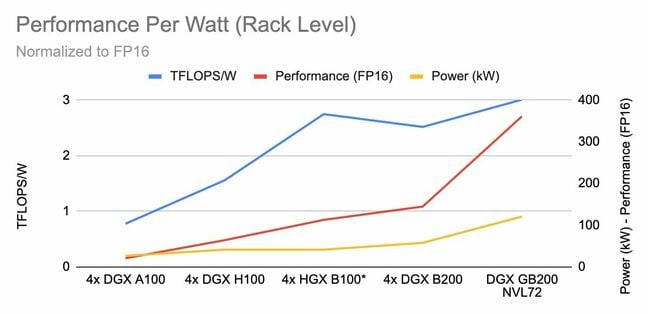

当我们加入恩维迪亚的能量饥饿GB200NVL72和它的120千瓦的胃口时,我们可以更好地看待这个问题。

在机架尺度,我们比较了四个DGX风格系统每个机架与单一的GB200NVL72设置。我们又看到了一个熟悉的趋势。尽管水冷系统的GPS运行比DGXB200热200W,但Rak规模系统能够发挥2.5倍的性能,同时耗电略超过两倍。

从图表中,你还可以看到,液体冷却的NVL系统实际上是最高效的,毫无疑问,因为它没有将15%-20%的能量投入风扇。

此外,您还需要为设施设备提供动力,如冷却剂分配单元(CDU),这些数字没有考虑到,但空气处理程序也不需要冷却传统系统。

在这里,我们可以从数据中心操作员的实际角度出发,就布莱克威尔的意义得出一些结论。

恩维迪亚的HGX仍然是一个安全的赌注

英伟达最新的布莱克韦尔HGX载波板在GTC24展示。-点击放大

恩维迪亚的布莱克威尔发电公司最大的吸引力之一是电力和热能。你给这些芯片的能量越大,你就能把它们保存得越冷,它们的表现越好--达到某一程度。

如果你的设备正处于能够支持nviya的dgxh100的边缘,那么b100应该不会更难管理,至少根据我们的估计,在风冷系统中,它看起来是更有效的选择。

虽然dgxb200在满负荷时可能没有那么有效,但它仍然比b100盒快28%。在现实世界中,芯片很少24/7直奔红线,两者可能比他们在纸上看到的更接近。

无论在哪种情况下,你仍然可以看到比料斗的计算密度有很大的提高。四个DGXB200盒能够替换9-18H100系统,这取决于你是否可以利用布莱克威尔的p4精度。

越来越少、越来越密集的衣架指向了液体冷却的未来数据中心运营商可能面临的更大挑战之一是机架功率密度更高。有四个箱子在一个架子,我们看到大约50%的电力和冷却需求比H100系统。

如果你的数据中心不能支持这些密集的配置,那么你可能被迫选择两个节点架,有效地消除了布莱克威尔可能为你节省的空间。如果你的模型没有变得更大,或者你可以适应更长的训练时间,并利用布莱克韦尔宽敞的192gbm3e,这可能不是什么大事,但是如果你的模型已经增长,或者你的训练或精细的调谐时间表已经萎缩,这可能会证明有点头疼。

gb200nvl72是一个小型系统,它使用nv链接开关设备将36个格雷斯-布莱克韦尔超级芯片缝在一起,形成一个单一的系统。-点击放大

对于gb200nvl72的范围来说情况略有不同。超过22个HGXH100系统可以浓缩成这些液体冷却系统中的一个。或者用另一种方式,在支持一个模型所需的空间中,你现在可以支持一个5.5倍大的。

尽管如此,如果你想把布莱克威尔的潜能全部发挥出来,那么这样做将需要液体冷却。

好消息是,我们所看到的很多比特谷仓宣布支持nvi并不的DGXH100系统,包括电磁和数字房地产,已经在使用一种液体冷却形式--通常是使用后门热交换器--但DTC正在变得越来越普遍。

其中一些后门配置声称支持100千瓦或更多千瓦的热排斥,所以理论上你可以将其中一个系到Nvl72,并将热量倾倒到热通道。你的设施空气处理工是否能完全应付这是另一回事。

因此,我们怀疑液体到液体的CDU将会成为这样密集的冷却机架的首选方法。

NIM上的NIM软件执行官卡里布里斯基,CUD和DOGFOO丁AI 随着人工智能的繁荣,核电站附近的土地变成了热门的房地产 不管是不是泡沫,英伟达都把一切都押在了加速全球化的未来上 一个架子。120千瓦。仔细看看恩维迪亚的dgxGb200nvl72野兽 不仅仅是失败在黄延森的主旨演讲中,他对布莱克韦尔的推理性能做了更大胆的断言,他说,在引用1.8万亿参数混合专家模型时,它比霍珀一代的推理速度快30倍。

NVIDIA说,它的NVL72在推理工作负载中的性能最高可达30倍,在类似的H100安装程序旁边--点击扩大

从细节上看,我们看到有许多因素对这些收益起了作用。在未完成的成绩方面,与在fp8上运行的h100相比,下降到pp4网的布莱克韦尔表现最出色。

布莱克韦尔还自夸拥有1.4倍更多的hbm,正好提供了1.38x更多的内存带宽,每gpp记录到8tb/s,相比之下,h100的3.35tb/s。

然而,额外的故障和内存带宽本身并不足以解释推理性能的30倍提升。这里的脚注提供了一些线索。

结果:基于对指延迟时间=50mm;实时的第一标记延迟时间=5000mm;输入序列长度=32768;输出序列长度=1024输出,8xHGXH100风冷8x8gx网络与18gb200超级芯片液化冷却:NVL36,每GPU性能比较。预期业绩可能会改变。

在霍普配置中,每个服务器都有八个H100S,可以通过一个快速的900GB/SNvL链接交换织物相互交谈。然而,一个1.8万亿的参数模型不适合一个服务器。在fp8中,这样的模型将需要至少1.8Tb的内存,再加上键值缓存的一些额外容量。因此,我们需要更多的盒子,这些盒子必须通过400GB/s的无限波段网络相互通信。这意味着,每个GPU的总带宽为100GB/秒,这与NV链接相比是一个相当大的瓶颈。

相比之下,在NVIDIA的NVL系统中,每个GPU以1.8Tb/s的速度相互连接。更重要的是,较低精度的fp4数学将所需内存从1.8tb削减到900gb,同时也降低了带宽需求,这在理论上应该会提高吞吐量。

虽然NVIDA的NVL系统在运行大规模的万亿以上参数模型时可能有优势,但似乎布莱克威尔的估计铅比跳率要小得多,因为这些模型可以装在一个盒子里。

对于可复制的恩维迪亚的推理结果最终将会是怎样,还有待观察,但是销售的建议是明确的。一个NVL机架可以替代比系统的浮点性能更多的H100节点,这可能会让你相信--当然,如果你碰巧是在规模上的参考万亿加参数模型。无障碍的